🔔 Le projet de la DARPA sur un firmware auto réparateur

Toute l’actu cyber de la semaine, présentée par un expert. Cette semaine on revient sur les fuites de données de Deepseek, l'évaluation des hallucination des genIA ou le projet de la DARPA sur un firmware auto réparateur...

La DARPA démarre un projet de création d’un firmware auto-réparateur

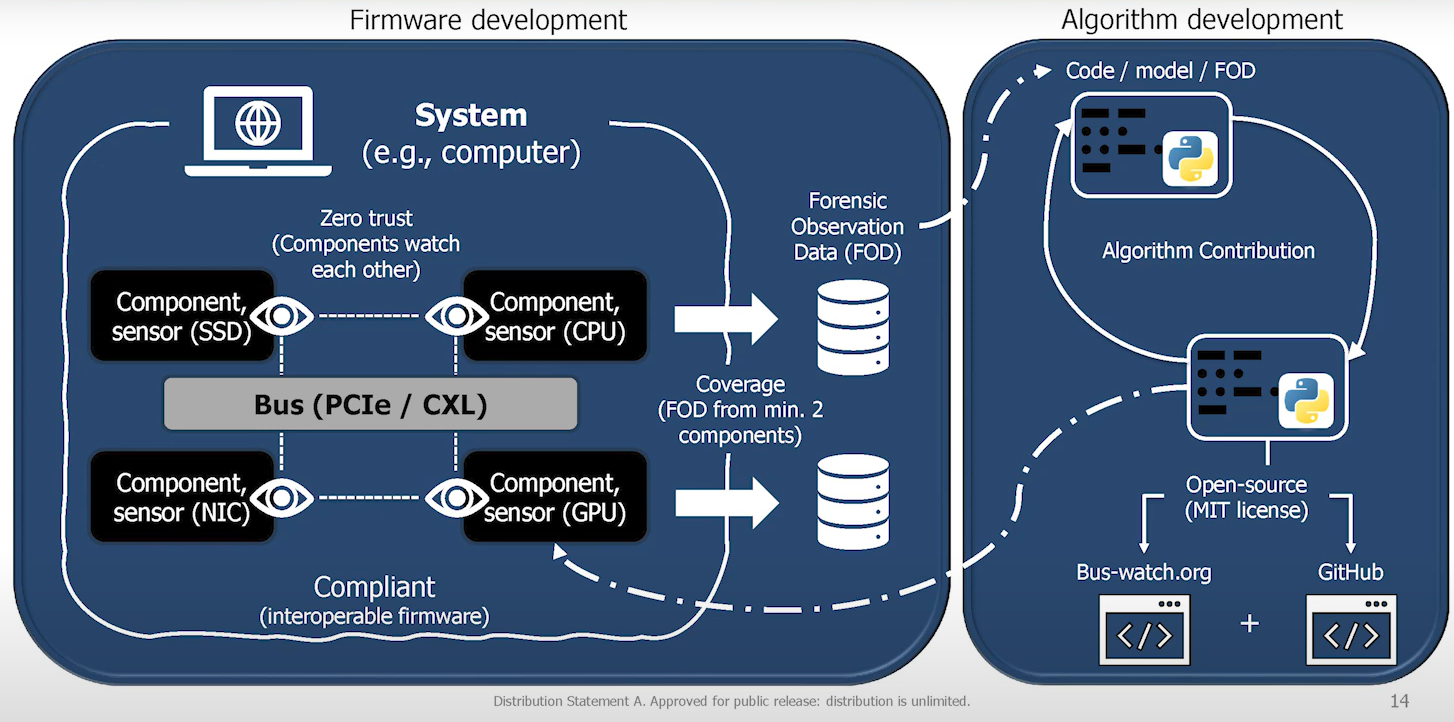

La DARPA a lancé le programme Red-C visant à développer un firmware "auto-réparateur" pour les systèmes informatiques basés sur des bus, tels que PCIe et CXL. Ce firmware intégrerait des capteurs forensiques permettant aux composants de détecter et de répondre en temps réel aux cyberattaques, tout en restaurant les données compromises. L'objectif est de créer une couche de sécurité distribuée au niveau du bus, offrant une surveillance interne plus efficace que les outils externes traditionnels. Cependant, des défis technologiques et d'adoption par l'industrie subsistent pour concrétiser cette vision.

Pourquoi c’est important ?

Les bus sont des éléments clés de l’informatique, transportant les informations d’un point à un autre au sein d’un ordinateur. En raison de ce rôle fondamental, ils bénéficient d’un niveau de confiance quasi total, et peu de vérifications sont effectuées sur les données qu’ils transmettent. C’est précisément ce que la DARPA cherche à corriger avec son nouveau firmware, en ajoutant une couche supplémentaire à la cybersécurité. L’objectif est de permettre aux composants de détecter les usages malveillants de leurs bus et, potentiellement, de s’auto-réparer. Cependant, ce projet en est encore à ses débuts et, même s’il aboutit, il faudra plusieurs années avant que l’industrie ne puisse le déployer à grande échelle.

Mesurer les vulnérabilité causée par les hallucinations de librairies sur les IA génératives

Une étude sur les LLM montre qu’ils génèrent parfois des références à des packages existants, un risque exploitable par des attaquants pour introduire du code malveillant. Le taux d’hallucination varie selon le modèle et le langage (allant jusqu’à 46 % pour Python). Les auteurs soulignent également une corrélation inverse entre le taux d'hallucination et les performances aux benchmarks de codage, suggérant que l'optimisation des modèles pour des performances élevées pourrait réduire les hallucinations.

Pourquoi c’est important ?

Les LLM se sont imposés comme des outils incontournables pour les développeurs, remplissant le même rôle que Stack Overflow et autres plateformes d'entraide. Cependant, contrairement à ces sites, les IA sont sujettes à des hallucinations, c'est-à-dire à la génération de contenu sans fondement. Dans notre cas, cela concerne les noms de packages inexistants, que certains hackers ont rapidement exploités en créant des packages malveillants pour compromettre le code des développeurs. Les chercheurs recommandent donc des stratégies défensives, telles que la vérification rigoureuse des dépendances et l'amélioration des LLM afin de minimiser ces vulnérabilités.

L’application DeepSeek transmet des données utilisateurs sans encryption

Un audit de l'application mobile DeepSeek pour iOS a révélé des failles de sécurité majeures, notamment la transmission de données sensibles sans chiffrement, les exposant à des risques d'interception et de manipulation. L'évaluation, menée par NowSecure, souligne l'utilisation d'algorithmes de chiffrement obsolètes et de clés codées en dur, ainsi que la désactivation de la protection App Transport Security (ATS) d'iOS. De plus, les données sont envoyées vers des serveurs gérés par Volcano Engine, une plateforme appartenant à ByteDance, la société mère de TikTok. Ces découvertes s'ajoutent aux préoccupations croissantes concernant la confidentialité et la sécurité des utilisateurs de DeepSeek.

Pourquoi c’est important ?

DeepSeek, la dernière IA générative en date, n’a pas tardé à se retrouver au cœur de polémiques. Après la fuite d’une partie de sa base de données contenant des conversations, elle est désormais impliquée dans une autre violation de données sensibles. Son application sur l’App Store transmettait en effet les informations de connexion en clair sur le web, exposant ainsi les utilisateurs à d’éventuelles attaques.

Des attaques sur les repos proxy de Maven

Backdoor dans du matériel médical chinois

La base de donnée de conversation de DeepSeek se retrouve sur le web

👉 A la semaine prochaine pour d’autres actus cyber !